还记得今年3月Meta CEO扎克伯格(Mark Zuckerberg)晒出的这张与英伟达CEO黄仁勋的合照吗?当时小扎称,黄仁勋是“科技界的Taylor Swift”。

这被认为是两个亿万富翁的世纪会面。

而就在刚刚,北京时间7月30日凌晨,黄仁勋与扎克伯格两人再度现身计算机图形学顶会SIGGRAPH 2024上,不仅迎来 AI 行业的世纪对谈,探讨 AI 和虚拟世界的基础研究与未来。而且最后,小扎送黄仁勋一件定制皮衣,黄仁勋用自己标志性的“全新”皮衣与扎克伯格交换,留下了精彩一刻。

(资料图)

(资料图)

扎克伯格在对谈中表示,从互联网到移动互联网之后,Facebook这类软件在苹果iOS系统平台上受到了极大的限制,而如今,以Llama为首的开源AI模型将成为打败苹果封闭生态、微软PC平台的下一个新的至宝。“我非常乐观地认为,在下一代比赛中,开源 AI 将会为Meta赢得胜利。”

“我未来10年或15年的事情之一,就是我只想确保Meta能够建立基础技术,并将在此基础上建立社交体验,因为我已经尝试了太多的东西。

如果你刚刚被告知,在某种程度上,你需要通过平台来构建它,我只是想,不,去他妈的下一代(fuck that for the next generation),就像我们要一直往下构建,并确保在那里。”扎克伯格再度炮轰苹果封闭生态对于Meta公司的打击。

黄仁勋则强调,AI 正在变革一切。而“我们(英伟达十年前)改变了公司的一切,从处理器到系统,再到软件堆栈,所有的算法和视频基础研究都转向深度学习。”

老黄小扎对谈:开源AI正变革互联网时代

“This is SIGGRAPH, these 90 % PhDs.”一上台,黄仁勋就调侃了小扎,称这个会议上的人90%都是博士,暗指小扎辍学创立Facebook的事情。

相比于大学本科期间就打造出Facebook并退学创业的扎克伯格,黄仁勋是在30岁才成为英伟达的联合创始人。于是他提到:“我要是知道得花这么长时间才能成功的话……”

“你打从一开始就不会做这些了?”扎克伯格问道。

“不,我会像你一样从大学辍学然后早点开始。” 黄仁勋表示。

实际上,英伟达和Meta之间的关系颇有渊源。当全球最强开源模型LLaMA一代推出之时,Meta采用英伟达A100 GPU卡进行训练,如今最新的Llama 3则是英伟达H100进行训练推理形成的。

早前扎克伯格承诺,到今年年底,Meta将拥有35万块英伟达H100 GPU,算力总和将接近于60万块H100所能提供的算力,预计投入成本高达70亿美金以上。

扎克伯格在对话当中表示,Meta有一套算力集群训练技术方案。如今,多模态模型对于算力要求越来越高,而 AI 已经深入到每家公司,在这其中构建GPU基础设施和运行大型推荐系统变得异常重要。

谈到开源 AI,扎克伯格有些激动的表示,开源 AI 模型技术将成为 AI 时代下打败闭源模型的重要动力。

“所以在这方面(Meta)有很多历史。随着时间的推移,我们做了很多开源工作。坦率地说,我认为部分原因是我们在其他一些科技公司之后开始建设分布式计算基础设施和数据中心。正因为如此,当我们建造这些东西的时候,它并不是一个竞争优势。所以我们想,好吧,我们最好把它打开,然后我们将受益于围绕它(开放)的生态系统。所以我们有很多这样的项目。我认为,最大的一个可能是开放计算,我们采用了服务器设计和网络设计。最终,数据中心设计并发布了所有这些内容。通过让它成为某种行业标准,所有的供应链基本上都围绕它组织起来,这对每个人都有省钱的好处。”扎克伯格表示。

黄仁勋也同意开源 AI 的重要性,也支持Meta公司的愿景。他表示,模型开源之后,每个人都可以有个AI ,每个企业都可以有一个AI,每个工程师和每个软件开发人员都有一个AI。“我相信你也相信每个人和每个公司都应该能够制造自己的AI,所以你(Meta模型)实际上是开源的。”

“所以这是一项非常棒的体验。当Llama出现的时候,我们有点积极地倾向于为 AI 模型做这件事。具体来说,我想我有几种方式来看待这个问题。我的一个想法是,在过去的20年里,在公司里建造东西真的很有趣。但最困难的一件事是,我们必须通过竞争对手的移动平台(苹果)发布我们的应用程序。所以一方面,移动平台对这个行业来说是巨大的恩惠,这是非常棒的。

但另一方面,通过你的竞争对手来交付你的产品是具有挑战性的。在我成长的那个时代,Facebook第一个版本是在网络上,而且是开放的。然后作为向移动设备的过渡,有利的一面是,现在每个人的口袋里都有一台‘电脑’。所以那很好。但缺点是,我们能做的事情受到了更多的限制。当你看这几代计算时,有一种很大的限制和偏见,每个人都只看着移动设备,认为因为封闭的生态系统,因为苹果基本上赢了,并制定了条款。

从技术上讲,我知道市面上有更多的安卓手机,但苹果基本上拥有整个市场和所有的利润。基本上,安卓在发展方面有点像苹果。所以我认为苹果很明显赢得了这一代人。但并不总是这样。或者即使你回到一代人以前,苹果也在做他们那种封闭的事情。

但是微软,显然不像这个完全开放的公司,但与苹果相比,Windows运行在所有不同的原始设备制造商和不同的软件,不同的硬件上。这是一个更加开放的生态系统和窗口。Windows是领先的生态系统。它基本上是那种PC时代的东西,开放的生态系统之一。我有点希望,在下一代计算中,我们将回到开放生态系统获胜并处于领先地位的领域。然后,总会有一个封闭的和一个开放的。我认为两者都有理由去做,两者都有好处。我不是这方面的狂热者,并不是我们发布的所有东西都是开放的。

但我认为,总的来说,对于整个行业正在构建的计算平台来说,这是很有价值的。如果软件特别开放,这真的塑造了我的哲学,无论是与Llama AI,还是我们在AR和VR方面所做的工作,我们基本上是在做基于开源技术的系统架构,比如在AR上构建系统。因此,从某种意义上说,Android或Windows基本上是这样的,但我们将能够与许多不同的硬件公司合作,制造各种不同的设备。我们基本上只是想把生态系统恢复到开放的水平。”扎克伯格这一段言论,直接炮轰苹果封闭系统对于Meta产品和收入的影响。

随后,扎克伯格就开启了“fuck”之旅,他说“让我谈论封闭的平台,我就会生气”。

黄仁勋随后继续称赞Meta的开源愿景,认为这种方式能让所有人使用 AI 技术。

随后谈及虚拟现实的发展,扎克伯格指出,利用现有非常高质量的 AI 技术,AR技术能够在全息AR出现之前以非常快的速度变得更好。“幸运的是,我们处于有利地位,因为我们正最终得到只是一系列不同价位、不同技术水平的眼镜产品。所以我认为,基于我们现在看到的雷朋Meadows,我会猜测 AI 眼镜在300美元的价位上将会是一个量级非常大的产品,数千万或数亿人最终将会拥有(它)。”

“我们开始建立一个GPU芯片。现在,当您部署GPU时,您仍然将其称为H100。所以你们知道,当扎克伯格称它建立拥有60万H100的数据中心的时候,我认为出现了好‘顾客’。但这件事太不可思议了我有一个巨大的系统,非常难以协调、难以运行。你说你进入GPU的旅程比大多数人都晚,但你的规模比任何人都大。我祝贺你所做的一切真是难以置信,这真是个时尚偶像。”黄仁勋在演讲结尾表示。

NVIDIA NIM时代已来

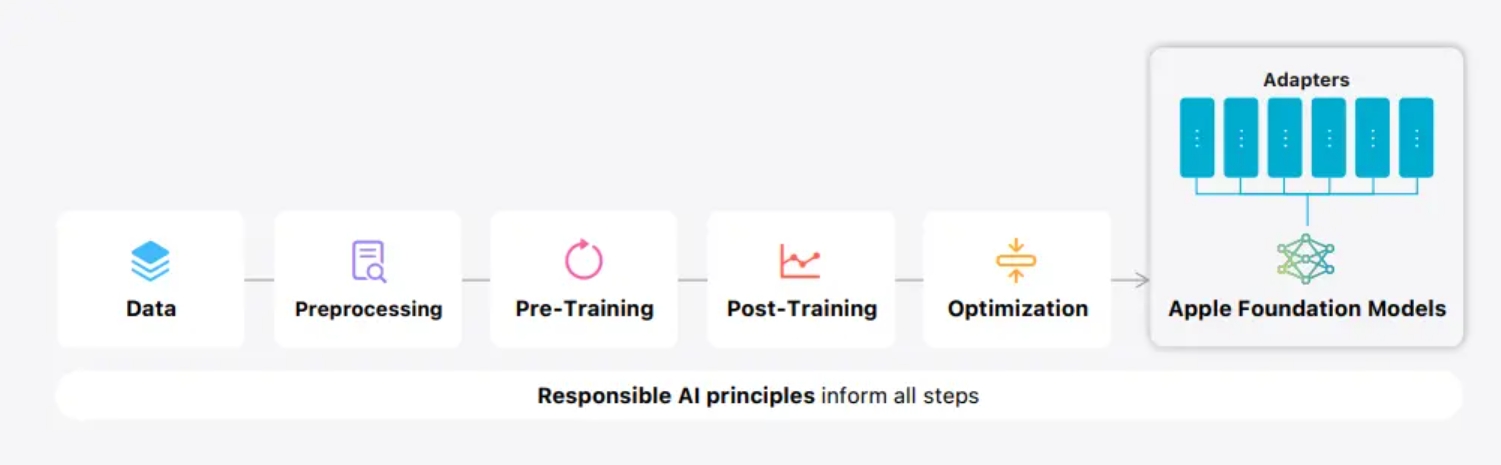

值得注意的是,伴随这次访谈,本次SIGGRAPH 2024上,英伟达公布20多份研究论文和产品。其中,黄仁勋重点展示了一项英伟达的“第二曲线”业务——推理微服务NVIDIA NIM。

7月29日,英伟达推出了一套全新的NIM微服务,专门针对不同工作流提供定制服务,包括OpenUSD、3D建模、物理学、材质、机器人、工业数字孪生和物理AI,旨在赋能开发人员,特别是在DGX Cloud上集成Hugging Face推理即服务。

同时,Shutterstock还推出了一项生成式3D服务。而在AI和图形领域,英伟达发布了全新的OpenUSD NIM微服务和参考工作流,专为生成式物理AI应用而设计。这包括一项通过面向机器人仿真的全新NIM微服务来加速人形机器人开发计划。

实际上,所谓英伟达Nvidia inference microservices(NIMs)是通过经优化的容器的形式提供模型,以部署在云、数据中心或工作站上,是NVIDIA AI Enterprise业务的一部分。借助 NVIDIA NIM,全球超过2800万名开发者能够轻松地为Copilots、聊天机器人等构建生成式 AI 应用,所需时间从数周缩短至几分钟。

简单来说,你可以理解为NIM是一种软件模型服务即平台,与无问芯穹推理模型服务、Hugging Face有点类似。

事实上,随着2022年底OpenAI推出ChatGPT聊天机器人产品,GPT大模型技术在几个月内积累了超过 1 亿用户,几乎推动了各行各业的开发活动激增。

而到了2023 年,开发者开始使用 Meta、Mistral、Stability等公司的 API 和开源社区模型创建模型或技术服务。

如今,2024年起,企业组织正将注意力转向大规模生产部署,其中包括将 AI 模型连接到现有企业基础设施、优化系统延迟和吞吐量、日志记录、监控和安全性等。但是,这种生产路径既复杂又耗时,需要专门的技能、平台和流程,尤其是大规模部署。

就在此时,NVIDIA NIM应运而生。

今年3月,英伟达首次公布该产品,并在 今年6月Computex电脑展上正式宣布,包括Cadence、Cloudera、Cohesity、DataStax、NetApp、Scale AI 和新思科技等近200家技术合作伙伴正在将 NIM 集成到他们的平台中,以加快特定领域应用的生成式 AI 部署,例如Copilot、代码助手和数字人虚拟形象等。另外,从 Meta Llama 3 开始,在 Hugging Face 上现已开始提供 NIM。

黄仁勋在今年6月表示:“每个企业都希望在其运营中融入生成式 AI,但并非每个企业都拥有专门的 AI 研究团队。NVIDIA NIM 可被集成到任意平台中,任何地方的开发者都可以访问,并且可以在任意环境中运行——它正在助力科技行业将生成式 AI 普及到每一个企业组织。”

具体来说,NVIDIA NIM主要有五个优势:

随时随地部署:NIM 专为可移植性和可控性而构建,支持跨各种基础设施 (从本地工作站到云再到本地数据中心) 进行模型部署。其中包括 NVIDIA DGX、 NVIDIA DGX 云、 NVIDIA 认证系统、 NVIDIA RTX 工作站和 PC。预构建的容器和 Helm Chart 打包了优化模型,并在不同的 NVIDIA 硬件平台、云服务提供商和 Kubernetes 发行版中进行了严格验证和基准测试。这支持所有 NVIDIA 驱动的环境,并确保组织可以在任何地方部署其生成式 AI 应用,同时保持对其应用及其处理的数据的全面控制。使用行业标准 API 进行开发:开发者可以通过符合每个领域行业标准的 API 访问 AI 模型,从而简化 AI 应用的开发。这些 API 与生态系统中的标准部署流程兼容,使开发者能够快速更新其 AI 应用 (通常只需 3 行代码)。这种无缝集成和易用性有助于在企业环境中快速部署和扩展 AI 解决方案。利用特定领域的模型:NIM 还通过几个关键功能满足了对特定领域解决方案和优化性能的需求。它包含特定于领域的 NVIDIA CUDA 库,以及为语言、语音、视频处理、医疗健康等各个领域量身定制的专用代码。这种方法可确保应用程序准确无误并与其特定用例相关。在优化的推理引擎上运行:NIM 针对每个模型和硬件设置利用经过优化的推理引擎,在加速基础设施上提供尽可能好的延迟和吞吐量。这降低了在扩展推理工作负载时运行推理工作负载的成本,并改善了最终用户体验。除了支持优化的社区模型外,开发者还可以通过使用从未离开数据中心边界的专有数据源对模型进行对齐和微调,从而实现更高的准确性和性能。支持企业级 AI:作为 NVIDIA AI Enterprise 的一部分,NIM 采用企业级基础容器构建,通过功能分支、严格的验证、通过服务级别协议提供的企业级支持以及针对 CVE 的定期安全更新,为企业 AI 软件提供坚实的基础。全面的支持结构和优化功能突出了 NIM 作为在生产环境中部署高效、可扩展和定制的 AI 应用的关键工具的作用。

与此同时,开发者可以使用 NVIDIA 托管的云 API 测试新的生成式 AI 模型,或者通过下载 NIM 来自行托管模型,并在主要云提供商或本地使用 Kubernetes 快速部署,以减少开发时间、复杂性和成本。而且,NIM 微服务通过打包算法、系统和运行时优化并添加行业标准 API 来简化 AI 模型部署流程。

因此,借助 NIM,企业可以优化其 AI 基础架构,以更大限度地提高效率和成本效益,而无需担心 AI 模型开发的复杂性和容器化。在加速 AI 基础架构的基础上,NIM 有助于提高性能和可扩展性,同时降低硬件和运营成本。

另外,基于NIM,英伟达还提供跨不同领域定制模型服务。比如,NVIDIA NeMo使用专有数据为大模型、语音 AI 和多模态模型提供微调功能;NVIDIA BioNeMo通过生成生物学化学和分子预测模型集合加速药物研发;NVIDIA Picasso通过Edify模型实现更快的创意工作流程。这些模型在视觉内容提供商的许可库中进行训练,从而能够部署自定义的生成式 AI 模型,以创建视觉内容。

目前,开发者现在可以从 Hugging Face AI 平台上,访问 Meta Llama 3 模型的 NVIDIA NIM 微服务。通过基于 NVIDIA GPU 的 Hugging Face 推理端点,只需点击几下,开发者就能在其选择的云平台上轻松地访问和运行 Llama 3 NIM。

具体到案例中,英伟达透露,作为全球最大的电子制造商,鸿海集团(Foxconn)正在使用 NIM 开发针对特定领域的大模型,并将这些模型嵌入到其 AI 工厂的各种内部系统和流程中,用于智能制造、智慧城市和智能电动汽车;而西门子正在将其运营技术与 NIM 微服务整合,用于车间 AI 工作负载,此外西门子还利用NIM为Machine Operators 构建了一个本地部署版本的 Industrial Copilot。

另外,英伟达称,数十家医疗公司正在一系列应用中部署 NIM,以便在手术规划、数字助手、药物研发和临床试验优化等一系列应用中为生成式 AI 推理提供动力。而且,埃森哲、德勤、Infosys、Latentview、Quantiphi、SoftServe、塔塔咨询服务(TCS)和威普罗(Wipro)已经建立了 NIM 能力,以帮助全球企业快速开发和部署生产型 AI 策略技术。

黄仁勋曾表示,未来,每台设备都将运行 AI 软件。因此,各个国家必须要做自己的主权 AI,而当前,企业以及制定主权 AI 战略的国家正希望创建具有特定领域知识的自定义大语言模型,以便生成式 AI 应用能够反映其独特的业务或文化。因此,这些新服务的推出恰逢其时。

黄仁勋强调,英伟达用“加速计算”技术重新发明了计算机。在过去的8年里,英伟达提高了每个GPU芯片性能,AI 算力性能提高了1000倍。

“现在,你可以拥有一台搭载GPU显卡、速度快100倍、能效高20倍、成本低20倍的计算机,能够解决复杂问题以及 AI 技术。”黄仁勋称,“事实上,我创造了‘加速计算’这个词。”

黄仁勋解释说,机器人技术需要三台计算机:一台用于训练AI,一台用于在精确的物理模拟环境中测试AI,另一台则安装在机器人内部。

“几乎每个行业都将受到这项技术的影响,无论是科学计算以更少的能源更好地预测天气,还是与创作者合作生成图像,或为工业可视化创建虚以场景。生成式AI还将彻底改变机器人自动驾驶汽车领域。”黄仁勋表示。

黄仁勋强调,未来,客户服务这一职业仍将由人类主导,但会有AI参与其中。所有这些创新技术,就像任何新工具一样,都有望增强人类的生产力和创造力。“想象一下,有了这些工具,你将能够讲述哪些新故事。”